昨天有小伙伴问:“怎么把智谱的模型接到Claude Code里?我都设置好环境变量了,还是提示没有apikey。” 看到问题后,我马上就去研究了,现在把教程整理出来分享给大家。

GLM-4.5 模型亮点速览

周一晚上,智谱正式发布了新一代旗舰模型GLM-4.5,而且还是开源的。这次发布了两个版本,都采用MoE(混合专家)架构,支持混合推理模式:

- GLM-4.5(旗舰版):总参数量335B,激活参数32B;

- GLM-4.5-Air(轻量版):总参数量106B,激活参数12B。

以前的大模型,有的数学能力强,有的推理能力突出,各有侧重。但GLM-4.5不一样,它堪称“三项全能”——原生融合了推理、代码编写和Agent能力,在开源模型里都是顶尖水平。

在12项基准测试(包括MMLU-Pro、AIME 24、MATH-500、SciCode等)中,GLM-4.5的表现很亮眼。上线没几天,就冲到了Hugging Face热榜全球第一,在开发者圈子里讨论度特别高。

我自己也第一时间上手试了试,跑了几个任务,效果比预想中稳定。尤其是它的中文理解能力,确实很出色。

接下来,我就手把手教大家把GLM-4.5接入Claude Code。整个过程不用翻墙,操作也简单,用Claude Code的界面搭配智谱的模型,体验特别好。

实测案例:GLM-4.5 能力展示

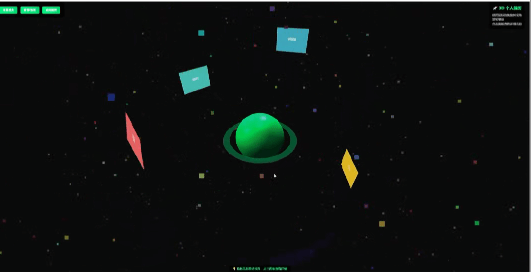

案例1:3D网页开发

提示词:用Three.js做一个3D个人简历页面,把教育经历、项目经验、技能等内容做成在空间中漂浮的面板,围绕核心头像旋转。用户点击某部分内容时,该内容要通过动画放大并居中显示,同时展示详细信息。

生成的3D个人简历页面,用鼠标可以旋转视角,点击图标能查看详情,用一句话就生成了动态3D页面,很适合做个人简历或作品集。

案例2:前端网页开发

提示词:开发一个类似Bing的搜索网站。

生成的前端页面结构合理,配色和布局都挺美观,基本实现了Bing搜索的核心界面功能。

案例3:新闻聚合与热点图谱

提示词:用HTML+JavaScript开发一个网页应用,功能要求:用户输入关键词(比如“人工智能”)后,页面能抓取相关新闻并生成热点概念图谱。具体包括:支持从RSS或API获取最新新闻(可模拟数据);对新闻内容进行聚合、摘要和关键词提取;根据词频和共现关系构建概念图谱;页面包含关键词输入框、新闻摘要区、热点图谱区。

最终生成的页面包含了所有要求的区域,结构清晰,信息展示也很规整。

案例4:BUG修复

提示词:

// React 中某个组件报错:TypeError: Cannot read property 'map' of undefined

export default function TaskList({ tasks }) {

return (

<ul>

{tasks.map(task => (

<li key={task.id}>{task.title}</li>

))}

</ul>

);

}

请找出错误原因并修复

这个错误其实很常见,就是tasks参数可能是undefined,但代码直接调用了tasks.map()方法。

具体来说,tasks参数出现undefined的情况可能有:

- 父组件没有传递tasks属性;

- 异步数据还没加载完成;

- API请求返回的数据为空。

下面是几种修复方案:

方案1:添加默认参数(比较推荐)

// 给tasks设置默认值为空数组,避免undefined的情况

export default function TaskList({ tasks=[]}) {

return (

<ul>

{tasks.map(task => (

<li key={task.id}>{task.title}</li>

))}

</ul>

);

}

方案2:添加条件检查

// 先判断tasks是否存在,不存在就显示提示信息

export default function TaskList({ tasks }) {

if (!tasks) {

return <div>暂无任务数据</div>;

}

return (

<ul>

{tasks.map(task => (

<li key={task.id}>{task.title}</li>

))}

</ul>

);

}

方案3:使用可选链操作符

// 用?.操作符,只有当tasks存在时才会调用map方法

export default function TaskList({ tasks}) {

return (

<ul>

{tasks?.map(task => (

<li key={task.id}>{task.title}</li>

))}

</ul>

);

}

方案4:完整的错误处理(个人觉得最推荐)

// 不仅处理undefined,还检查数据类型和内容结构

export default function TaskList({ tasks=[]}) {

// 检查tasks是否为数组

if (!Array.isArray(tasks)) {

console.warn('TaskList: tasks is not an array', tasks);

return <div>数据格式错误</div>;

}

// 数组为空时显示提示

if (tasks.length ===0) {

return <div>暂无任务</div>;

}

return (

<ul>

{tasks.map(task => {

// 检查每个task对象的结构是否正确

if (!task || !task.id || !task.title) {

console.warn('TaskList: invalid task object', task);

return null;

}

return <li key={task.id}>{task.title}</li>;

})}

</ul>

);

}

最佳实践建议:用{ tasks=[] }设置默认参数,是最简洁的解决方式,能防止整个应用因为这个错误崩溃。

GLM-4.5 接入 Claude Code 步骤详解

其实现在在智谱清言(https://chatglm.cn)或Z.ai(https://chat.z.ai/)上,已经能直接体验GLM-4.5了。不过这次我用的是智谱API接入Claude Code,用API测试更方便,也更贴近实际开发场景。

第一步:获取API Key

- 打开网址https://bigmodel.cn/usercenter/proj-mgmt/apikeys ,登录后创建一个新的API Key。

- 注意:新版的API Key格式是

{id} {secret},也就是同时包含用户标识id和签名密钥secret。 - 复制生成的API Key,后面配置的时候要用。

这里提醒一下,API Key要妥善保管,别随便分享给别人,也别暴露在浏览器或客户端代码里。平台如果发现密钥泄露,可能会自动更换。

第二步:安装依赖

首先要安装Node.js,直接去官网https://nodejs.org 下载安装就行,步骤很简单,一路默认下一步即可。

安装完成后,打开cmd终端,输入下面两个命令,检查是否安装成功:

node -v

npm -v

如果能看到版本号,就说明安装成功了。比如我这里显示的是:

C:\Users\WIN>node -v

v22.17.1

C:\Users\WIN>npm -v

10.9.2

第三步:安装Claude Code

在终端里输入下面的命令,安装Claude Code:

npm install -g @anthropic-ai/claude-code

安装完成后,需要配置环境变量。

如果是Windows用户,在cmd终端输入:

set ANTHROPIC_BASE_URL=https://open.bigmodel.cn/api/anthropic

set ANTHROPIC_AUTH_TOKEN=前面获取的智谱API Key

如果是Mac/Linux用户,命令是:

export ANTHROPIC_BASE_URL="https://open.bigmodel.cn/api/anthropic"

export ANTHROPIC_AUTH_TOKEN="前面获取的智谱API Key"

这里划个重点:https://open.bigmodel.cn/api/anthropic是智谱提供的专用接口,兼容Anthropic API协议。配置好这个接口地址后,默认用的就是GLM-4.5。

第四步:启动并验证

接着在终端输入:

Claude

这时候会出现一个提示,问是否信任当前文件夹的文件,Claude Code可能会读取或执行该文件夹里的文件。直接按回车确认就行。

之后会看到类似下面的界面,就说明配置成功了:

Welcome to Claude Code!

/help for help, /status for your current setup

cwd: C:\Users\WIN

Overrides (via env):

API Base URL: https://open.bigmodel.cn/api/anthropic

Tip: Hit Enter to queue up additional messages while Claude is working. Try "edit <filepath> to..."

? for shortcuts

到这里,就可以直接在输入框里写提示词使用了。

一些额外分享

以前,推理、代码、Agent这三个方向的模型各有擅长,现在开始融合了。GLM-4.5就是这样,不是某一项特别突出,而是整体水平都很均衡,国产模型终于有了通用性的底气。

把GLM-4.5接入Claude Code,实际用下来比我想的简单。调用起来很流畅,成本也能接受,整体感觉就是——够用、好用,适合实际开发干活。

而且它开源了,API定价也很友好。输入只要0.8元/百万tokens,输出2元/百万tokens,高速版每秒最高能处理100 tokens。

| 模型 | 上下文分段(tokens) | 输入价格(元/M) | 输出价格(元/M) |

|---|---|---|---|

| GLM-4.5 | 输入0-32且输出0-0.2 | 2(最低) | 8(最低) |

| 输入0-32且输出0.2+ | 3(最低) | 14(最低) | |

| 输入32-128 | 4(最低) | 16(最低) | |

| GLM-4.5-Air | 输入0-32且输出0-0.2 | 0.8(最低) | 2(最低) |

| 输入0-32且输出0.2+ | 0.8(最低) | 6(最低) | |

| 输入32-128 | 1.2(最低) | 8(最低) | |

| Kimi K2 | – | 4 | 16 |

| DeepSeek-R1 | – | 4 | 16 |

| Claude 4 Sonnet | – | 21.5(3美元) | 107.4(15美元) |

| Qwen-3-Coder | 输入0-32 | 4 | 16 |

| 输入32-128 | 6 | 24 | |

| 输入128-256 | 10 | 40 | |

| 输入256-1M | 20 | 200 |

目前官网API在搞限时五折活动,新用户还直接送两千万tokens。

就像美国科技网站Techi说的,中国AI正在靠开源和低价打破技术门槛,慢慢走到全球竞争的核心区域。看这趋势,国产AI确实有领跑的可能。

好了,以上就是全部内容,有问题欢迎在评论区交流。